人工智能应用带来了许多挑战,包括数据处理和内存。三星希望通过结合内存处理和高带宽内存来解决这些问题。

今年的热芯片33会议带来了很多有趣的技术专注于人工智能(AI)和高带宽存储器(哈佛商学院)。其中一家公司,尤其是三星展示了整合在它的两个设备中,一个是HBM,另一个是内存处理(PIM),它将在AI算法和应用程序中处理大量数据。

内存处理架构超越了HBM,包括DRAM模块和移动内存。图片使用由三星

在这篇文章中,让我们深入了解三星在Hot Chips 33上的表现,以及这对HBM世界的意义。

三星的PIM抢走了热门芯片的风头自1998年以来,热芯片一直是一个世界著名的会议领导半导体行业,展示先进的高性能微处理器和集成电路(IC)。

在今年的活动中,三星展示了人工智能技术内存生态系统的最新集成解决方案 HBM-PIM公司系统。这个组合使用锡林克斯阿尔维奥人工智能加速器系统,声称可以将整个系统性能提高2.5倍的标准速率,能耗降低70%。

锡林克斯的阿尔维奥人工智能加速器。图片使用由锡林克斯

更快的速率和更少的能量消耗对人工智能应用至关重要。人工智能算法和应用程序面临的一些问题来自于大量的数据,而当前的存储设备没有足够的容量和带宽来满足这些数据。

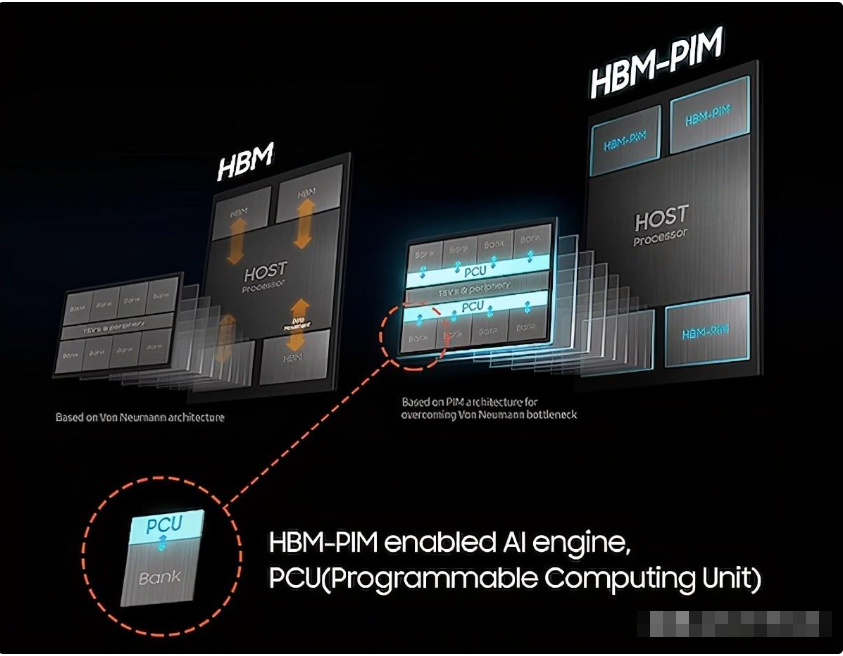

如果系统不能处理所有输入的数据,内存系统的计算性能就会受到影响。三星集成PIM的计划应该允许一些数据在内存设备中本地保存和处理,从而减少流量。

数据处理在人工智能应用中是必不可少的,需要一个重新设计的存储设备。

如HBM-PIM,以实现AI加速器引擎支持的计算逻辑。

PIM的功能从集成计算和内存开始,使内存设备能够在本地执行任何操作。

使用PIM,三星可以消除对工业标准逻辑设备和内存解决方案的需求,这些设备通常执行CPU、GPU和NPU等计算。这种内存解决方案不仅节省了系统的占用空间,而且还最大限度地减少了延迟,提高了处理速度,并提高了整体能效。

三星电子(Samsung Electronics)负责DRAM产品和技术的高级副总裁金南成(Nam Sung Kim)认为,HBM的未来在于这项技术的标准化。一旦实现了这一点,应用程序的数量就可以增加,并扩展到下一代超级计算机和人工智能应用程序的HBM3中,包括用于设备人工智能的移动存储器和用于数据中心的存储模块。

既然三星已经制定了更多关于HBM和PIM的计划,让我们看看它的发布。

Aquabolt XL和AXDIMM三星不仅介绍了HBM-PIM背后的理念和研究成果,还分享了新的设备,这些设备将结合基于人工智能的功能,以增强超级计算机和算法的高速数据处理能力。

Aquabolt XL是三星的预期产品之一,它的特点是在装有保险丝的HBM设备内安装了一个名为可编程计算单元(PCU)的AI引擎。

对于大型数据集,计算和内存受限的人工智能应用所需的容量和带宽的增加就是为什么需要HBM-PIM,三星将该PIM并入其中,以增强HBM的功能。

Aquabolt XL采用PCU,可在内存系统的核心内实现并行处理。通过添加HBM设备,整个体系结构是健壮的,并且为高数据流量做好了准备。

HBM的核心是PCU引擎,但总体架构是什么?

HBM是通过堆叠构建的德拉姆模具相互重叠,允许并行访问每个DRAM模具。HBM高度的内部并行性对整个过程至关重要。

与单纯使用HBM相比,涉及语音识别的人工智能应用程序的性能提高了2倍。在DRAM芯片内部发生相同数量的计算的情况下,与移动数据相关联的IO流量被消除,从而导致功耗降低。

AXDIMM是一种CPU内存数据移动,可以避免系统中出现瓶颈,使用PIM将有助于此平台。

三星发布的第二款产品是它的加速DIMM(AXDIMM),支持对DRAM模块的处理,最大限度地减少CPU和DRAM之间的大数据移动。

这种数据移动的最小化可以提高所有人工智能加速器系统的能源效率。本质上,这个芯片作为一个缓冲区,里面有一个人工智能引擎。AXDIMM可以执行多个内存列组(DRAM芯片集)的并行处理,而不是一次访问一个列组。总的来说,这个模块听起来很有前途,因为它可以保留传统的DIMM形式,而AXDIMM则成为一个不需要修改系统的直接替代品。

为了保持双倍统计的主题,三星的AXDIMM在基于人工智能的应用程序中提供了两倍的性能,整体系统的能耗降低了40%。

同样,尽管前景看好,但看到三星在HBM方面如何发展PIM将是一件很有趣的事情。

与内存系统性能无关一旦三星开始融合PIM和HBM,就不需要额外的工作来将PIM与其他行业标准的存储系统结合起来,比如低功耗双数据速率(LPDDR)和图形双数据速率(GDDR)。集成的便利性可能会为PIM打开许多大门。

工程师、计算机架构师和技术爱好者预计,三星将在2022年扩大其人工智能内存产品组合,包括所有PIM技术。三星公司的领导者们需要继续推出基于人工智能的自动语音识别系统,并计划推出更大容量的智能语音识别系统。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。